| プラン | 料金 | 高速トークンリセット | トークン繰越 | 同時生成数 | 生成キュー | 動画生成 |

|---|---|---|---|---|---|---|

| 無料プラン | 無料 | 1日150回 | なし | 1つ | 最大5つ | ウォーターマークあり |

| アプレンティスプラン | $10 / 月 | 毎月8,500回 | 25,500トークン | 2つ | 最大5つ | ウォーターマークなし |

| アルチザン無制限プラン | $24 / 月 | 毎月25,000回 | 75,000トークン | 3つ | 最大10個 | ウォーターマークなし |

| マエストロ無制限プラン | $48 / 月 | 毎月60,000回 | 180,000トークン | 6つ | 最大20個 | ウォーターマークなし |

| Leonardo for Teams | プランに応じて | プランに応じて | プランに応じて | プランに応じて | プランに応じて | プランに応じて |

WordPressにおけるsite_urlとhome_urlの違い

WordPressにおけるsite_urlとhome_urlの違いは、次のようになります。

site_url

- WordPressがインストールされているディレクトリのURLを指します。

- 例: WordPressが

https://example.com/wpにインストールされている場合、site_urlはhttps://example.com/wpになります。

home_url

- ブログのトップページ(ホームページ)のURLを指します。一般的には訪問者がアクセスするサイトのURLになります。

- 例:

https://example.comがブログのトップページの場合、home_urlはhttps://example.comです。

つまり、site_urlはWordPressの実際のインストールディレクトリのURLを指し、home_urlは訪問者がサイトにアクセスするためのトップページのURLを指します。

具体例:

- ブログのトップページ(home_url):

https://example.com - WordPressのインストールディレクトリ(site_url):

https://example.com/wp

この違いは、WordPressをサブディレクトリにインストールして、ホームページを異なるURLに設定している場合などで役立ちます。

Let's Encrypt のディレクトリ構成

Let's Encrypt のディレクトリ構成は、取得した証明書や設定ファイルが保存される重要なフォルダを含んでいます。以下に各フォルダの役割を説明します。

- accounts/

- このディレクトリには、Let's Encrypt の ACME サーバーに登録されたアカウント情報が保存されます。ACME クライアント(Certbotなど)はこのアカウント情報を使用して、証明書の取得や更新を行います。

- 具体的には、アカウントキーや登録情報が保存されており、サブディレクトリとして登録された ACME サーバーごとにディレクトリが作成されます。

- archive/

- このフォルダには、取得したすべての証明書の古いバージョンが保存されます。証明書が更新されるたびに、新しい証明書が

live/ディレクトリに配置され、古い証明書はarchive/ディレクトリに移動されます。 - ここには、証明書(

cert.pem)、秘密鍵(privkey.pem)、中間証明書(chain.pem)、およびそれらの全体をまとめた証明書(fullchain.pem)が含まれます。

- このフォルダには、取得したすべての証明書の古いバージョンが保存されます。証明書が更新されるたびに、新しい証明書が

- live/

live/ディレクトリには、現在有効な証明書が保存されます。ウェブサーバーなどのアプリケーションは、このディレクトリの証明書と鍵を参照します。- 各ドメインごとにサブディレクトリが作成され、その中に現在有効な証明書ファイル(

cert.pem、privkey.pem、chain.pem、fullchain.pem)が含まれます。

- renewal/

- このディレクトリには、証明書の更新に関する設定ファイル(

*.conf)が保存されています。これらの設定ファイルは、証明書をどのように更新するかを指定します。 - 例えば、ドメイン名や証明書に関連する情報が記述されています。Certbotはこの設定ファイルをもとに、自動で証明書の更新を行います。

- このディレクトリには、証明書の更新に関する設定ファイル(

- renewal-hooks/

renewal-hooks/ディレクトリには、証明書の更新時に実行されるスクリプトが保存されます。これらのスクリプトは、証明書の更新後に行う必要がある処理(例えば、ウェブサーバーの再起動など)を自動で行うために使用されます。- このディレクトリには

pre/、post/、deploy/のサブディレクトリがあり、それぞれ更新前、更新後、デプロイ時に実行されるスクリプトを配置します。

これらのディレクトリが適切に管理されることで、Let's Encrypt を使用した証明書の発行・更新が円滑に行われます。

Claude 3のAPIを使用してGitHub Actionsでプルリクエストのコードレビュー(未検証)

Claude 3のAPIを使用してGitHub Actionsでプルリクエストのコードレビューを自動化することは可能です。以下に、その実装の概要を説明します:

- GitHub Actionsのワークフローを設定する:

プルリクエストが作成されたときに実行されるワークフローを.github/workflows/ディレクトリに作成します。 - プルリクエストの変更を取得する:

GitHub APIを使用して、プルリクエストで変更されたファイルと内容を取得します。 - Claude 3 APIを呼び出す:

取得したコードの変更をClaude 3 APIに送信し、レビューを要求します。 - レビュー結果を処理する:

Claude 3からの応答を解析し、有用なフィードバックを抽出します。 - GitHub上でコメントする:

GitHub APIを使用して、プルリクエストにコメントを投稿します。

以下は、この処理を実装するPythonスクリプトの簡単な例です:

import os

import requests

from github import Github

from anthropic import Anthropic

# GitHub認証情報とリポジトリ情報を設定

github_token = os.environ["GITHUB_TOKEN"]

repo_name = os.environ["GITHUB_REPOSITORY"]

pr_number = os.environ["PR_NUMBER"]

# Claude API認証情報を設定

anthropic_api_key = os.environ["ANTHROPIC_API_KEY"]

# GitHubクライアントを初期化

g = Github(github_token)

repo = g.get_repo(repo_name)

pr = repo.get_pull(int(pr_number))

# プルリクエストの変更を取得

changes = pr.get_files()

# Claude 3クライアントを初期化

anthropic = Anthropic(api_key=anthropic_api_key)

# 各変更ファイルに対してレビューを実行

for file in changes:

file_content = repo.get_contents(file.filename, ref=pr.head.sha).decoded_content.decode()

# Claude 3にレビューを要求

prompt = f"以下のコードをレビューしてください:\n\n{file_content}\n\nコードの問題点や改善点を指摘してください。"

response = anthropic.completions.create(

model="claude-3-opus-20240229",

prompt=prompt,

max_tokens_to_sample=1000

)

review_comment = response.completion

# GitHub上でコメントを投稿

pr.create_review_comment(body=review_comment, commit=pr.head.sha, path=file.filename, line=1)

print("コードレビューが完了しました。")

このスクリプトを使用するには、以下の手順が必要です:- 必要なPythonライブラリ(

requests,PyGithub,anthropic)をインストールします。 - GitHub ActionsのワークフローYAMLファイルで、必要な環境変数(

GITHUB_TOKEN,ANTHROPIC_API_KEY,PR_NUMBER)を設定します。 - このスクリプトをGitHub Actionsワークフローの一部として実行します。

このアプローチにはいくつかの注意点があります:

- APIの使用量と関連コストを考慮する必要があります。

- センシティブな情報や機密コードを外部APIに送信することについて、セキュリティ上の懸念がある場合があります。

- AIによるレビューは人間のレビューを完全に置き換えるものではなく、補完するものとして考えるべきです。

実際に実装する際は、エラーハンドリングやレート制限の管理、より詳細なコードコンテキストの提供など、さらなる改良が必要になるでしょう。

このアプローチに興味がある場合、さらに詳しい実装方法や最適化について説明しますので、お気軽にお尋ねください。

locate と plocate

locate と plocate は、どちらもシステム内のファイルを高速に検索するためのツールですが、次の点で異なります。

locate

- バージョン: 4.9.0-5

- パッケージ名:

mlocate - 特徴:

- 伝統的な

locateコマンドの実装です。 - 長い歴史があり、広く使用されています。

locateはデータベースの更新に時間がかかることがあり、大規模なシステムではやや遅いと感じることがあります。

- 伝統的な

plocate

- バージョン: 1.1.19-2ubuntu1

- 特徴:

plocateは、mlocateの代替として設計されており、特にパフォーマンスとリソースの効率性が改善されています。- データベースのサイズが非常に小さく、更新や検索がより高速です。

mlocateと互換性があり、同じインターフェースで使用できます。

どっちがいい?

plocate は、mlocate よりも新しく、特にパフォーマンスや効率性を重視しているため、一般的には plocate の使用をお勧めします。特に大規模なファイルシステムやリソースが限られた環境では、plocate の方がメリットが大きいです。

ただし、システムが小規模であり、従来の locate に慣れている場合は、mlocate (locate) を選択することも問題ありません。

Ubuntu 24.04で時刻を合わせ、タイムゾーンを東京に設定するには

Ubuntu 24.04で時刻を合わせ、タイムゾーンを東京に設定するには、timedatectlコマンドを使用します。以下の手順に従ってください。

1. 現在の時刻とタイムゾーンを確認する

まず、現在の時刻とタイムゾーンを確認します。

timedatectl

これで、現在のタイムゾーンが表示されます。

2. タイムゾーンを東京に設定する

タイムゾーンを東京(Asia/Tokyo)に変更するには、次のコマンドを実行します。

sudo timedatectl set-timezone Asia/Tokyo3. 時刻同期の確認と設定

NTP(Network Time Protocol)を使用して時刻が正確に同期されているか確認します。

timedatectl statusもしNTPが有効でない場合は、次のコマンドで有効にします。

sudo timedatectl set-ntp trueこれで、時刻が正確に同期され、タイムゾーンが東京に設定されます。

4. 設定の確認

再度、現在の時刻とタイムゾーンを確認して、設定が反映されているか確認します。

timedatectlこれで完了です。システムの時刻が正確に設定され、タイムゾーンが東京に設定されました。

sudoでパスワード無し

user1アカウントをパスワードなしでsudoコマンドを実行できるようにするには、/etc/sudoersファイルを編集する必要があります。以下の手順に従って設定してください。

visudoコマンドでsudoersファイルを安全に編集します。

sudo visudovisudoで開いたファイルの末尾に以下の行を追加します。

user1 ALL=(ALL) NOPASSWD:ALLこれは、user1ユーザーがすべてのホスト、すべてのコマンドに対してパスワードなしでsudoを実行できるようにする設定です。

ファイルを保存して終了します(Ctrl+Oで保存、Ctrl+Xで終了)。

安全性の観点から、この設定は慎重に行い、必要がない場合は使用しないようにしてください。

#

# This file MUST be edited with the 'visudo' command as root.

#

# Please consider adding local content in /etc/sudoers.d/ instead of

# directly modifying this file.

#

# See the man page for details on how to write a sudoers file.

#

Defaults env_reset

Defaults mail_badpass

Defaults secure_path="/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/snap/bin"

# This fixes CVE-2005-4890 and possibly breaks some versions of kdesu

# (#1011624, https://bugs.kde.org/show_bug.cgi?id=452532)

Defaults use_pty

# This preserves proxy settings from user environments of root

# equivalent users (group sudo)

#Defaults:%sudo env_keep += "http_proxy https_proxy ftp_proxy all_proxy no_proxy"

# This allows running arbitrary commands, but so does ALL, and it means

# different sudoers have their choice of editor respected.

#Defaults:%sudo env_keep += "EDITOR"

# Completely harmless preservation of a user preference.

#Defaults:%sudo env_keep += "GREP_COLOR"

# While you shouldn't normally run git as root, you need to with etckeeper

#Defaults:%sudo env_keep += "GIT_AUTHOR_* GIT_COMMITTER_*"

# Per-user preferences; root won't have sensible values for them.

#Defaults:%sudo env_keep += "EMAIL DEBEMAIL DEBFULLNAME"

# "sudo scp" or "sudo rsync" should be able to use your SSH agent.

#Defaults:%sudo env_keep += "SSH_AGENT_PID SSH_AUTH_SOCK"

# Ditto for GPG agent

#Defaults:%sudo env_keep += "GPG_AGENT_INFO"

# Host alias specification

# User alias specification

# Cmnd alias specification

# User privilege specification

root ALL=(ALL:ALL) ALL

# Members of the admin group may gain root privileges

%admin ALL=(ALL) ALL

# Allow members of group sudo to execute any command

%sudo ALL=(ALL:ALL) ALL

# See sudoers(5) for more information on "@include" directives:

@includedir /etc/sudoers.d

user1 ALL=(ALL:ALL) NOPASSWD: ALL

user2 ALL=(ALL:ALL) NOPASSWD: ALL

一番下に書かないと駄目です。

Nginx location ~ .php$ 解説

server {

listen 80;

listen [::]:80;

server_name localhost;

#access_log /var/log/nginx/host.access.log main;

#error_page 404 /404.html;

location / {

root /var/www/html;

index index.php index.html index.htm;

try_files $uri $uri/ /index.php?$args;

}

location ~ \.php$ {

include fastcgi_params;

fastcgi_pass phpfpm; # 上で定義したアップストリームを指定

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

}location ~ \.php$の~は、正規表現を使用したパターンマッチングを行うことを意味しています。この場合、次のような内容を表しています。

location ~ \.php$:locationディレクティブは、指定されたパスに一致するリクエストに対して、特定の処理を行うために使用されます。~は、正規表現を使用することを意味します。これにより、locationブロックの条件として、指定したパターンに一致するすべてのリクエストをキャッチします。\.php$は、.phpで終わるファイルパスに一致する正規表現です。\.は、.をリテラルとして扱うためにエスケープされています(通常、.は正規表現で任意の1文字を表します)。phpはそのまま「php」という文字列に一致します。$は、文字列の終わりを示します。つまり、phpで文字列が終わることを意味します。

この設定は、リクエストされたURLが.phpで終わる場合に、locationブロック内の設定(例えば、FastCGIの設定など)を適用することを意味しています。これにより、PHPファイルに対するリクエストが適切に処理され、PHP-FPMなどのバックエンドに渡されます。

Nginxのrootとindexディレクティブ:location内外での違いと適用範囲

1. locationブロック内にrootとindexを指定する場合

server {

listen 80;

listen [::]:80;

server_name localhost;

location / {

root /var/www/html;

index index.php index.html index.htm;

}

}- 適用範囲: この場合、

rootとindexの設定は、/で始まるリクエスト、つまりすべてのリクエストに適用されます。この設定により、Nginxは/var/www/htmlディレクトリをルートディレクトリとして使用し、そこからindex.phpやindex.htmlを探します。 - 特定のパスに限定:

locationブロック内に設定されているため、この設定は他のlocationブロックには影響しません。たとえば、別のlocation /images/ブロックがあった場合、そのブロックには影響を与えません。

2. locationブロックの外にrootとindexを指定する場合

server {

listen 80;

listen [::]:80;

server_name localhost;

root /usr/share/nginx/html;

index index.php index.html index.htm;

}- 適用範囲:

rootとindexがlocationブロックの外にある場合、これらの設定はそのserverブロック全体に適用されます。つまり、そのserverブロック内のすべてのlocationブロックにデフォルトのrootとindexの設定が適用されます。 - 全体のデフォルト設定: 他の

locationブロック内でrootやindexが明示的に設定されていない限り、これらのグローバル設定が適用されます。

違いのまとめ

location内で設定:rootとindexが特定のlocationブロックにのみ適用されます。- 他の

locationブロックには影響を与えません。

location外で設定:serverブロック全体にデフォルトのrootとindexが適用されます。serverブロック内のすべてのlocationブロックでこの設定がデフォルトとして使用されます。ただし、locationブロック内で上書きすることが可能です。

実際の使用例

location内で設定する場合: 特定のパス(例えば、/images/や/api/など)で異なるルートディレクトリやインデックスファイルを使用したい場合に有効です。location外で設定する場合: 全体のデフォルトとしてrootやindexを設定し、特別な場合にのみlocationブロック内で上書きするという使い方が一般的です。これにより、設定が簡潔になり、メンテナンスがしやすくなります。

iPod バッテリー交換について

iPod バッテリー交換について

この記事は相当古い記事です。

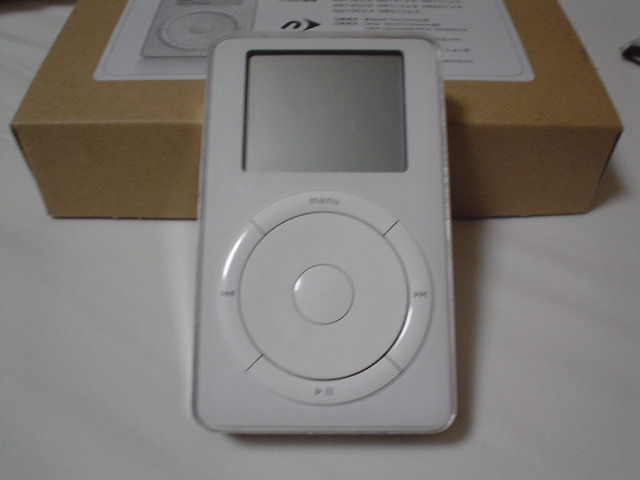

自分の所有しているiPodは初代発売された奴である。

容量は10GB

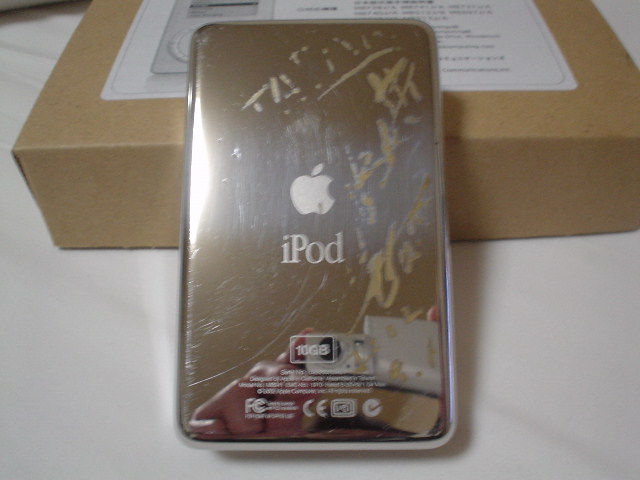

裏には「斉藤ノブ」さんにサインしてもらった。^^

渋谷の「JZ Bart」でライブを見に行った時にサインしてもらったのだ。

サインの日付が2002年 もうサインが剥げ掛けて、良く分からなくなってしまった。

最近はめっきり使用してない。

音楽をゆっくり聴く時間が無いと言ってよい。

ウーム・・・・

旅行に行くときは持っていく事にしてる。

タイ旅行へ行ったときは活躍してくれた。

小さいスピーカーを繋いで、浜辺で音楽聴きながら、酒でも・・

大したことじゃないですが、「SoundApp」って音声ファイル再生アプリを覚えているでしょうか?

とりあえずファイルを再生させるには便利なツールです。

起動も速いし。

「メニュー」の「ファイル」から「新規プレイリスト」を開いて、

そこにMacに接続されているiPodのアイコンをドラッグします。

なんとリストにはiPodの中の曲の一覧が!

そこから、書き出しなんてことも出来ちゃいます。

今ではそういったツールがMacOS X用にあるので必要ないのですが。

一様参考までに^^

質問は受け付けません。面倒くさいので(笑)

さて本題です。

長らく使ってきた所為か、バッテリーがもう駄目になってしまっていて、実用に耐えない。

そこでバッテリーを交換することにした。

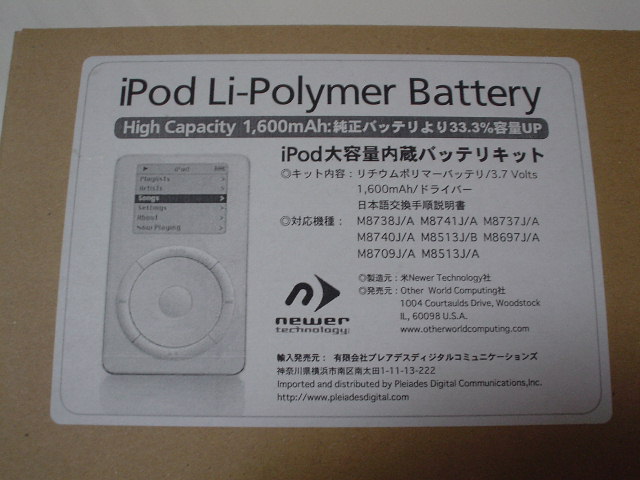

丁度「Newer Technology」から交換バッテリーが発売されていたからだ。

以下はiPodのバッテリー交換時の様子を記そうと思う。

購入したバッテリーの箱

まずiPodの裏蓋を外す。

Newer Technologyのバッテリーには裏蓋を外す工具が着いてくるので、それを利用したほうがいいです。

自分の場合は、バッテリーが届く前に、先走って蓋だけ開けてしまったのです。^^;

ネット上でiPodのバラシ方を検索するとテレホンカードみたいな薄いカードを隙間に差し込んで、グイっと外すと書いてあったので同じようにやりました。

これはとても大変です。簡単には開きません。

差し込んだカードがボロボロになってしまいました。^^;

カードで蓋を開ける人は、根気よく頑張ってください。壊してもイイぐらいの感じで ^^;

工具を使うと簡単に開きます。Newer Technologyのバッテリーを買うなら工具を使ってください。

バッテリーとハードディスクの間にグレーの色のゴムが2つ挟まっています。

自分のは本当に初期の初期だったらしく、バッテリーとゴムが接着されていました。

初期以降はただ単にゴムが挟んであるだけらしいので、簡単に取れるそうです。

バッテリーを取り外すとSONYと書いてありました。

写真はありませんが、ハードディスクは東芝製の1.8インチです。

最近では100GBのものが発売されているので、換装することも可能でしょう。

バッテリーの交換は簡単です。

単純に差し替えてください。

後は蓋を戻して、iPodのバッテリー交換完了です。